一、评测场景与参评模型概述

2024年6月25日,《每日经济新闻大模型评测报告》第1期发布,对15款市面主流大模型在“财经新闻标题创作”“微博新闻写作”“文章差错校对”“财务数据计算与分析”四个新闻采编应用场景的能力进行了评测。

2024年9月6日,《每日经济新闻大模型评测报告》第2期发布,重点考察大模型在“金融数学计算”“商务文本翻译”“财经新闻阅读”三个新闻采编应用场景的能力。

与前两期评测一样,《每日经济新闻大模型年度评测报告》继续以大模型在新闻采编场景的应用能力为评测目标,但为了更精准对接采编人员的实际需求,本次评测以“采写编审和短视频创作的新闻生产全流程”为场景,包括大模型设计采访提纲——撰写新闻稿件——校对稿件差错——提炼稿件标题——改写短视频文本五个细分场景。通过大模型在新闻生产全流程的介入,评测出“谁是新闻生产全流程的最优秀大模型”,用直观的评测结果,对采编人员在工作中选用适合的大模型工具提供实战参考。

本次评测设置的五个细分应用场景具体如下:

(1)设计采访提纲:旨在考察大模型能否帮助记者拟定采访提纲,辅助记者采访工作。

(2)撰写新闻稿件:旨在考察大模型围绕既定的多份材料,能否创作一篇新闻稿件。

(3)校对稿件差错:旨在考察大模型能否检查出新闻稿件中的错别字,语法、数字、标点符号等差错。

(4)提炼稿件标题:旨在考察大模型能否根据稿件内容,提炼新闻标题,特别是制作适合在微信等新媒体平台传播的新媒体风格标题。

(5)改写短视频文本:旨在考察大模型能否根据一篇文字新闻稿件,改写成适合短视频发布的文案。

每经大模型评测小组为五个细分场景制定了对应的评价维度和评分指标。每日经济新闻10余名首席、高级、资深记者编辑根据评价维度和评分指标,对各款大模型在五个细分场景中的表现进行评分,汇总各场景得分,最终得到参评大模型总分。

需要指出的是,本期评测是通过各款大模型的API端口,并在默认温度下完成。与公众用户使用的大模型C端对话工具存在差异。但是评测结果对用户在具体场景中选择合适的大模型工具,依然具有重要参考价值。

本期评测均在“雨燕智宣AI创作+”测试台上进行,一共有12款国内大模型参与。

评测时间为2024年10月18日,因此参评大模型均为截至10月18日的最新版本。

二、评测结果

评测结果显示,腾讯混元hunyuan-turbo以379.53的总分位居榜首,紧随其后的是智谱GLM-4-Plus获得368.6分,字节跳动doubao-pro-32k(240828版本)获得363分。

在五个细分场景方面,各家模型展现出不同的优势:

在设计采访提纲场景中,腾讯混元hunyuan-turbo与昆仑万维天工SkyChat-3.0两款模型均取得了93.33分的佳绩,并列第一。

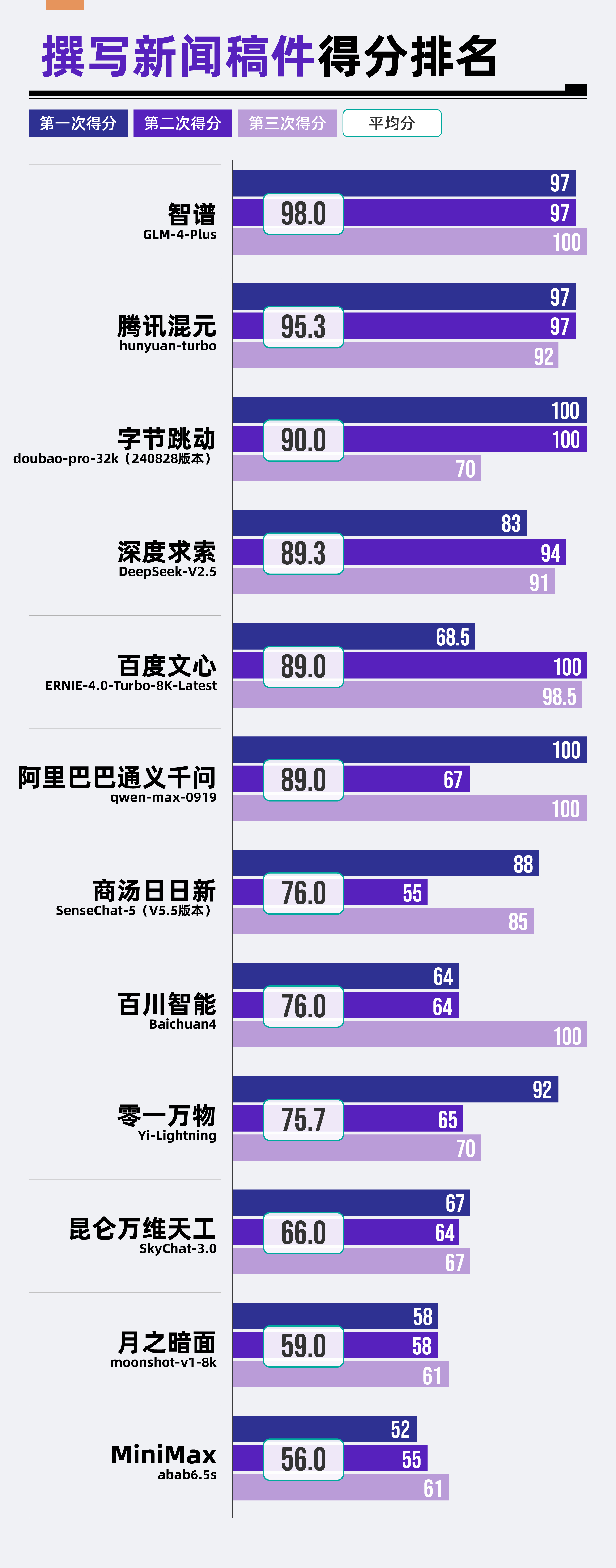

在撰写新闻稿件场景中,智谱GLM-4-Plus以98分的高分拔得头筹。

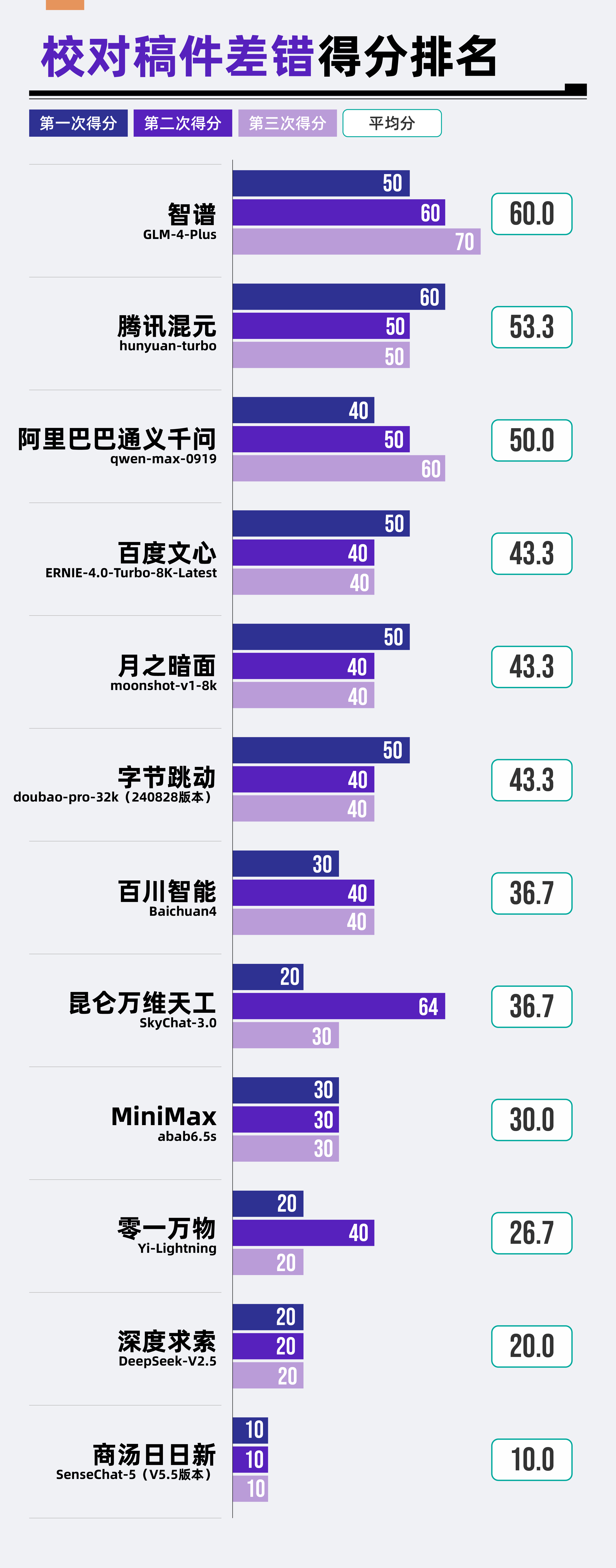

在校对稿件差错场景中,智谱GLM-4-Plus以60分的成绩位居首位。

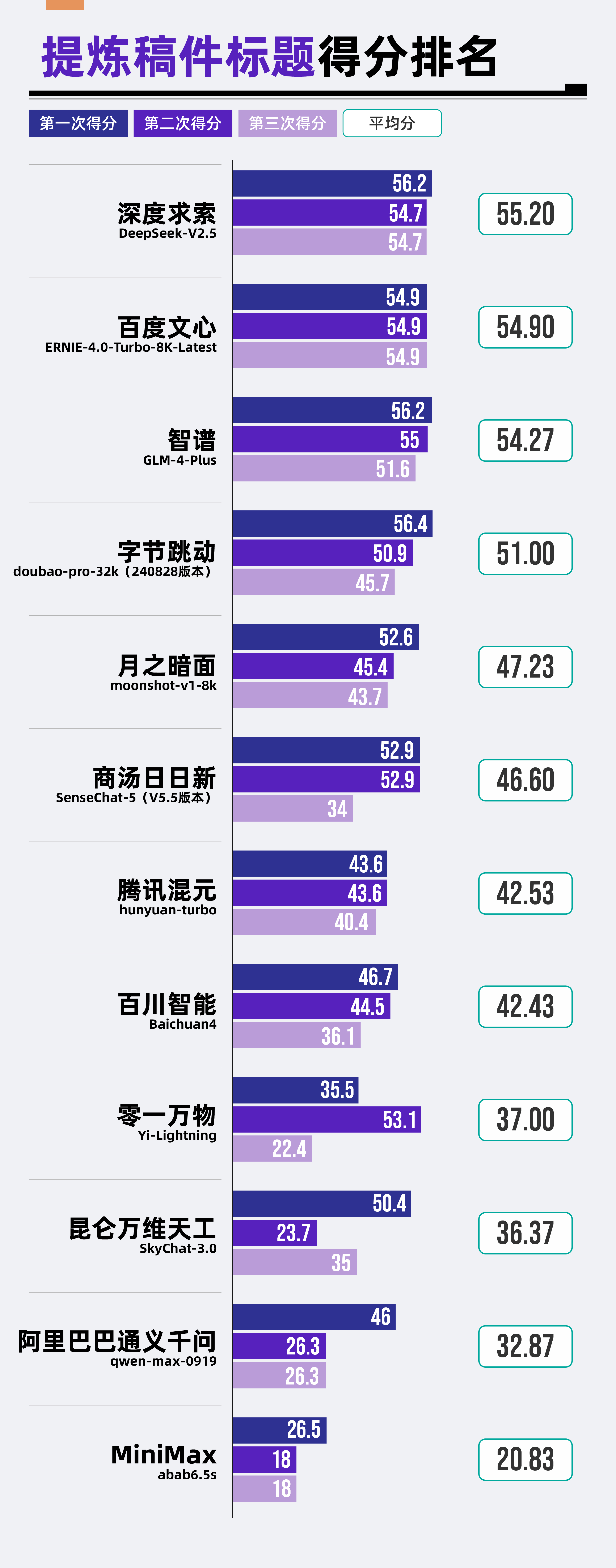

在提炼稿件标题方面,深度求索DeepSeek-V2.5模型以55.2分的成绩领先其他模型。

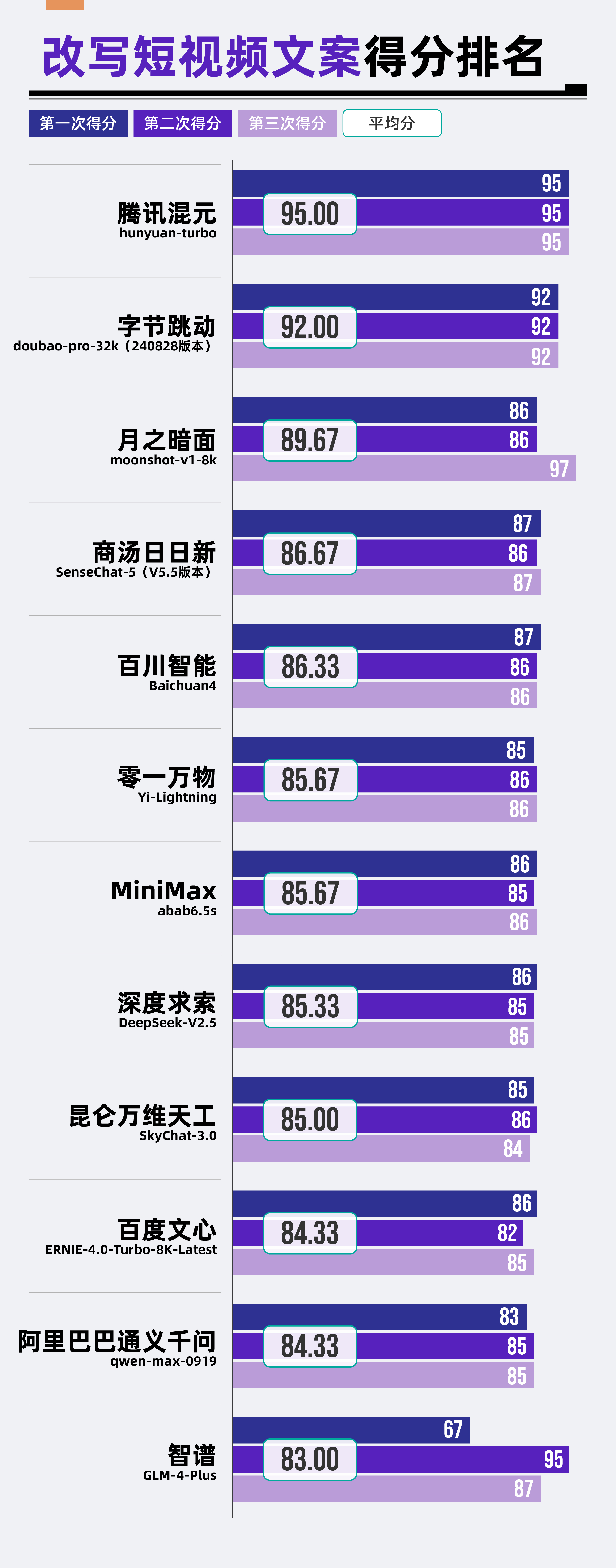

在改写短视频文本场景中,腾讯混元hunyuan-turbo再次展现其强劲实力,以95分的成绩位列第一。

1、评测场景一:设计采访提纲

(1)评测任务

采访是新闻生产的基础,需要记者进行大量的前期准备工作,包括收集采访资料、确定采访主题等。而设计采访提纲是将各项准备工作进行“集合式”整理,是记者综合能力和思考能力的体现。

本期评测的第一个场景“设计采访提纲”旨在检验各款大模型在构建采访结构,设计有深度的采访问题以及挖掘、分析信息方面的能力。

为此,评测小组首先针对采访对象收集了详尽的背景资料,接着要求大模型根据这些已有的背景资料,设计一份包含5个采访问题的采访提纲。

(2)评测结果

(3)结果分析

从整体结果来看,参评大模型在“设计采访提纲”场景中表现颇为出色。在12款大模型中,有8款模型的得分不低于80分,展现出较高的水平。

其中,腾讯混元hunyuan-turbo和昆仑万维天工SkyChat-3.0以93.33分的高分并列第一,零一万物Yi-Lightning、月之暗面moonshot-v1-8k、字节跳动doubao-pro-32k(240828版本)紧随其后,均展现出了不俗的实力。

然而,百度文心ERNIE-4.0-Turbo-8K-Latest在该场景下的表现则稍显逊色,位于榜单的最末位。

2、评测场景二:撰写新闻稿件

(1)评测任务

本次评测的第二个场景选择了“撰写新闻稿件”,旨在评估参评大模型是否能高效生成符合新闻专业标准的稿件内容。

评测小组向大模型提供了新闻写作主题、方向以及相关素材,并要求大模型根据要求和相关资料,撰写一篇完整的新闻稿件。

(2)评测结果

(3)结果分析

在撰写新闻稿件场景中,智谱GLM-4-Plus以总分98分的成绩排名第一。腾讯混元hunyuan-turbo、字节跳动doubao-pro-32k(240828版本)、深度求索DeepSeek-V2.5三款大模型紧随其后。相比之下,昆仑万维天工SkyChat-3.0、月之暗面moonshot-v1-8k及MiniMax abab6.5s在此方面的表现则稍显不足,分列该场景排名的后三位。

从各个维度综合评估,大模型在“新闻要素完整”与“新闻结构规范”两大方面展现出了卓越的表现,所有参与评测的12款大模型均在这两项维度上表现优异。

然而,真正使各款模型拉开分数差距的,在于“新闻信息准确”和“新闻要点全面”这两个维度。

该场景的前两名智谱GLM-4-Plus和腾讯混元hunyuan-turbo就在“新闻信息准确”维度上,均获得了满分,彰显其在信息筛选与核实上的高水准。相反,“吊车尾”的昆仑万维天工SkyChat-3.0、月之暗面moonshot-v1-8k以及MiniMax abab6.5s在该维度上的表现不尽如人意,这在一定程度上反映了它们在信息处理能力上的不足。

3、评测场景三:校对稿件差错

(1)评测任务

“校对稿件差错”需要对新闻事件进行核实,数据进行校准,并对文字、标点、语句等差错予以纠正,这是保证新闻稿件质量,出版内容准确不可或缺的一环,关系到新闻媒体的权威性以及公众对媒体的信任度。

因此,评测小组选择“校对稿件差错”作为本期评测的第三个场景,一方面考察大模型对细节的把控能力,另一方面也检验大模型结合上下文的分析能力。

评测小组在新闻稿中设置了10处错误,包括错别字、标点符号使用不当、事实和信息不准确等错误类型。

(2)评测结果

(3)结果分析

从本次评测的整体结果来看,“校对稿件差错”是本次五个评测场景中大模型表现最为薄弱的一环,总体平均分仅为37.78分,远低于预期。

从本次评测的在参评的12款大模型中,仅有智谱GLM-4-Plus一款大模型得到了60分的及格线。而零一万物Yi-Lightning、深度求索DeepSeek-V2.5以及商汤日日新SenseChat-5(V5.5版本)则分列倒数三位。

从具体题目来看,对于错别字、语法、数据和单位等相对简单的差错,多数大模型能够校对出来,并进行相应的纠正。但对于需要联系上下文,进行一定逻辑分析的新闻事实差错,大模型的校对能力还要亟待提升。

评测小组一共设置了3处事实和信息错误,遗憾的是,其中有2处错误让12款大模型集体“翻车”。在这两处错误上,没有一款大模型能够成功校对并予以纠正。

另外,评测小组还发现,参评大模型往往还会对一些原本正确的新闻内容给出错误的判断。

4、评测场景四:提炼新闻标题

(1)评测任务

新闻标题通过精炼的文字和巧妙的修辞手法,吸引读者眼球,激发阅读兴趣,是新闻传播的关键。

本期评测的第四个场景“提炼新闻标题”,旨在检验大模型能否通过阅读新闻稿件,准确抓住新闻点和新闻核心内容,并用简洁的语言,制作出精炼且富于感染力的标题;同时还考察大模型的语言运用能力,能否灵活运用修辞手法和语法结构,保证标题的逻辑性和准确性。

为此,评测小组选取了每日经济新闻的稿件作为测试样本,让大模型围绕稿件,提炼出符合新媒体传播的微信标题。

(2)评测结果

(3)结果分析

从整体结果来看,参评12款大模型中,没有一款能够达到60分的及格标准,平均分仅为43.44分,整体水平有待提升。

其中,深度求索DeepSeek-V2.5以55.2分的成绩位居榜首;百度文心ERNIE-4.0-Turbo-8K-Latest则以54.9分的微弱差距紧随其后,位列第二。这两款模型的表现相对突出,但仍未达到满意的水平。

而排名后三位的大模型昆仑万维天工SkyChat-3.0、阿里巴巴通义千问qwen-max-0919以及MiniMax abab6.5s表现则更加不尽如人意,得分分别为36.37分、32.87分和20.83分。

另外,值得注意的是,零一万物Yi-Lightning和昆仑万维天工SkyChat-3.0两款大模型在生成微信新闻标题时存在准确性和稳定性方面的问题,需要进一步优化和改进。在三次结果生成过程中,零一万物Yi-Lightning有两次出现了新闻标题的错误,而昆仑万维天工SkyChat-3.0也出现了一次错误。准确性是新闻报道的基本原则,而标题作为新闻稿件的“窗口”和“眼睛”更是不能出现任何差错。

评测小组发现,大模型整体得分偏低的主要原因,在于其生成的标题缺乏亮点,未能有效抓住稿件的新闻点或稿件中最具吸引力的内容,所以提炼的标题难以吸引读者眼球。此外,多个大模型生成的新闻标题中频繁出现一些过于“高大上”的抽象概念词汇,这不仅使得标题显得空洞而宽泛,还无形中增加了与读者之间的隔阂,进而削弱了读者阅读稿件的兴趣。

5、评测场景五:改写短视频文案

(1)评测任务

视频文案无疑是短视频的灵魂所在。好的短视频文案,能够通过精准而富有吸引力的文字,迅速抓住观众的注意力,引导观众深入了解短视频的详细内容,从而提升完播率。

本期评测的最后一个场景为“改写短视频文案”,这一场景旨在考察大模型在短视频文案创作中对信息的快速提炼,以及适应短视频平台风格的能力。

评测小组要求各款大模型把一篇文字新闻稿件,改写成语言精炼、观点明确且吸引观众的短视频文案。

(2)评测结果

(3)结果分析

从整体评测结果来看,“改写短视频文案”是五个评测场景中,大模型表现最为亮眼的一环。在这一场景中,所有参与评测的12款大模型均取得了超过80分的成绩,其中,有两款大模型更是以卓越的表现突破了90分的高分。

具体而言,腾讯混元hunyuan-turbo凭借其出色的实力,以95分的优异成绩稳居榜首;而字节跳动doubao-pro-32k(240828版本)也不甘示弱,以92分的佳绩紧随其后,展现出强劲的竞争实力。

腾讯混元hunyuan-turbo和字节跳动doubao-pro-32k(240828版本)的优异表现可能得益于腾讯和字节跳动这两大科技巨头在短视频领域的深厚积累。作为拥有自己短视频产品的公司,它们旗下的大模型在改写短视频文本方面可能拥有更为丰富的语料训练和更强的技术能力。

三、评测总结

结论一:暂无一款大模型能高质量完成采编全流程工作

截至目前,每日经济新闻一共推出三期大模型评测报告,覆盖12项新闻采编应用场景,但从结果来看,没有一款大模型能在所有场景中均排名前列。

正如人类一样,各款大模型的长处与短板各不相同。比如,有的大模型擅长财务数据计算,但在新闻标题提炼中却排名末尾;有的大模型擅长英译汉,却在汉译英方面能力平平。

在新闻生产的关键环节,如本期评测中的“撰写新闻稿件”“校对稿件差错”“提炼新闻标题”、第一期评测中的“财务数据计算与分析”和第二期评测中的“金融数学计算”等应用场景,多数大模型生成结果的差错频出,要保证新闻稿件的高质量、无差错,还必须由人工审核、把关。

目前市面上还没有一款大模型能够高质量、全流程完成新闻采编场景的所有工作,换句话说,世界上还没有“AI记者”。

结论二:大模型“幻觉”未解,错误更隐蔽

尽管各款大模型已经多次迭代升级,但依然解决不了“一本正经地胡说八道”的幻觉问题。

最初的大模型“幻觉”问题比较明显。随着产品不断迭代,大模型生成文本质量逐渐提升,但文本中的错误也越发隐蔽。比如,在“撰写新闻稿件”场景中,大模型会在不起眼处改变人物的职位或虚构事件发生的时间。例如在本期评测中,部分大模型将9月24日“星巴克咖啡公司宣布调整其中国领导层结构”的时间,误写成9月30日。再比如在第二期评测“金融数学计算”场景中,即便是得分第一的大模型也会在个别题目中给出了正确的计算公式,却依然得出错误的答案。

对于一篇高质量新闻稿件来说,上述问题都可能是“致命”的差错。目前,AI生成内容已经大规模出现在互联网中。这就要求新闻媒体要进一步完善新闻内容真实性审核机制,更需要加强内容把关。

结论三:“冷面”的大模型难判断新闻价值

阅读一篇稿件,挖掘出最重要的新闻点,然后提炼和制作标题,在这方面,大模型与经验丰富的编辑相比,差距不小。

在本期评测的“提炼稿件标题”场景中,大模型得分普遍偏低。其生成的标题多显得中规中矩。在本期评测的“提炼稿件标题”场景中,大模型得分普遍偏低。其生成的标题多显得中规中矩。例如大模型提炼的《“星巴克中国新篇章:80后刘文娟接任CEO,引领咖啡巨头迎挑战”》《“星巴克中国换帅:80后刘文娟接棒CEO,直面市场挑战与变革”》等标题。

另外,评测中发现,大模型提炼的新闻标题,往往充斥着一些“高大上”的抽象概念词汇,无法挖掘文章中最重要的新闻点和有价值的信息,文字空洞,很难吸引读者的眼球。

此外,在“撰写新闻稿件”场景中,大模型生成的文本较为生硬,“机器痕迹”较明显,缺乏情感和个性化的表达。

从现阶段来看,大模型在阅读文章方面,难以具备对一篇稿件新闻点的准确和深层次把握,容易停留在浅层次的理解。因此,新闻点和新闻价值的判断,包括采写有温度、有故事、有人情味的厚重稿件,仍然离不开记者、编辑的人工介入和悉心打磨。

结论四:不同采编场景选择最适合的大模型

三期大模型评测的场景基本可以分为辅助性场景(如财经新闻阅读、文本翻译、设计采访提纲等)和关键性场景(如撰写新闻稿件、校对稿件差错、提炼新闻标题等)。

三期评测的结果表明,绝大部分大模型在设计采访提纲、改写短视频文案、英汉翻译、文章阅读以及微博新闻写作等辅助性场景中普遍表现良好。例如,“改写短视频文案”场景中,所有参与评测的12款大模型均取得超过80分的成绩;而“设计采访提纲”场景中,有8款大模型的得分高于80分。在第二期评测的“商务本文翻译”场景中,13款大模型得分都高于80分,在“财经新闻阅读”场景中,13款大模型得分高于70分。

而在撰写新闻稿件、校对稿件差错、提炼新闻标题等新闻生产关键性场景的能力则明显不足。比如,在“校对稿件差错”场景中,仅一款大模型得分达到60分。在“提炼新闻标题”场景中,没有一款大模型得分达到60分。

因此,记者、编辑可以根据采编工作的不同环节,不同场景,选择最适合的大模型,让部分场景实现采编工作AI化,提升工作效率。

结论五:新闻媒体主导:打造垂直领域的“AI记者”

对比三期大模型评测结果不难发现,国内大模型通过持续迭代,能力稳步提升。同时,各家大模型之间的差距也在逐步缩小,每个模型都展现出独特的优势。但这些大模型都属于通用大模型,并非为新闻媒体、采编工作量身定制。

造成大模型“幻觉”问题严重的一大原因,在于训练文本和数据质量不高,其中包含不少信息错误。而新闻工作对准确性要求极高。这一短板直接限制了大模型在新闻领域的应用。然而,新闻媒体在长期的新闻报道中已经积累的大量高质量新闻稿件和数据,这恰恰为研发适合新闻采编工作的大模型工具提供了得天独厚的土壤。

因此,自主训练和主导研发大模型工具变得尤为重要,借此,新闻媒体不仅能够最大限度地确保大模型训练数据的质量和生成逻辑的准确性,还能保证大模型生成内容的可控性,使其更好地契合媒体自身的属性和特色。

在研发方法上,可以将采编全流程拆分成数十个环节,如采访、翻译、稿件写作、提炼摘要和校对差错等。根据各环节的具体工作目标、方法和要求,对大模型进行专项训练,以形成一系列单任务或垂类AI工具。最终,将这些单任务AI工具打包汇集,则可以打造出一整套新闻采编AI工具。

每日经济新闻大模型评测小组

2024年11月